Indeksowanie stron na przykład przez Google to jeden z głównych kroków, które musi wykonać wyszukiwarka, aby zawartość witryny pojawiła się w wynikach wyszukiwania.

Stosowane terminy to:

- crawling – proces przeszukiwania zawartości witryny, który sprowadza się do analizy treści znajdujących się na stronach, do których prowadzą odnośniki w danej witrynie.

- Web spider (crawler) – program, który służy do szybkiego przeprowadzania indeksowania na dużą skalę.

- Googlebot – aplikacja (automat odwiedzający strony) wykorzystywana przez firmę Google.

Indeksowanie odbywa się tak, że robot indeksujący określany jako Web Spider, który jest niczym innym jak aplikacją uruchomioną na serwerze danego usługodawcy np. Google, Bing, Baidu czy Yandex, wchodzi na naszą stronę WWW i przeklikuje się przez jej zawartość, symulując w ten sposób odwiedziny człowieka. Wykonując swoje zadanie indeksuje i zapisuje treści jakie są zawarte na stronie wraz z tymi zawartymi w nagłówku strony tzw. meta dane czyli tytuł strony, jej opis, słowa kluczowe, które jej autor zawarł.

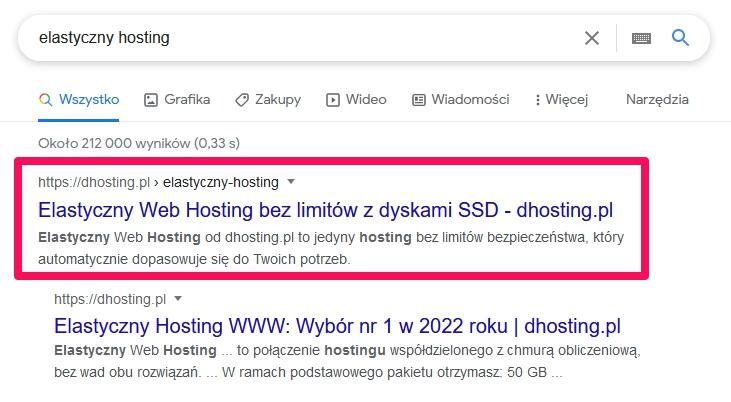

Proces taki określany jest crawlingiem, a jego skutkiem jest zapisanie w bazie danych usługodawcy / wyszukiwarki informacji na jakiej stronie WWW, pod jakim linkiem oraz z jakim opisem, możemy znaleźć konkretne informacje, które później są prezentowane użytkownikom danej wyszukiwarki w postaci pozycji na liście wyników wyszukiwania.